英伟达新科技:Spectrum-XGS如何终结AI算力瓶颈!

当今世界,人工智能的浪潮以前所未有的速度席卷而来。大型语言模型(LLM)的兴起,将人类带入了一个由数据和算法驱动的新时代。然而,这场革命的核心引擎——AI算力,正面临着前所未有的严峻挑战。随着模型参数的指数级增长,对算力的需求也呈几何级数爆发。谷歌在财报会议上披露的数据,形象地揭示了这一趋势:其应用程序在短短几个月内处理的tokens(令牌)数量从5月的480万亿翻倍,到7月底已超过980万亿 。与此同时,OpenAI、Claude等巨头仍不得不通过限制请求次数和响应长度来应对,这直观地表明,AI算力需求远未触及天花板,而现有供给已捉襟见肘 。

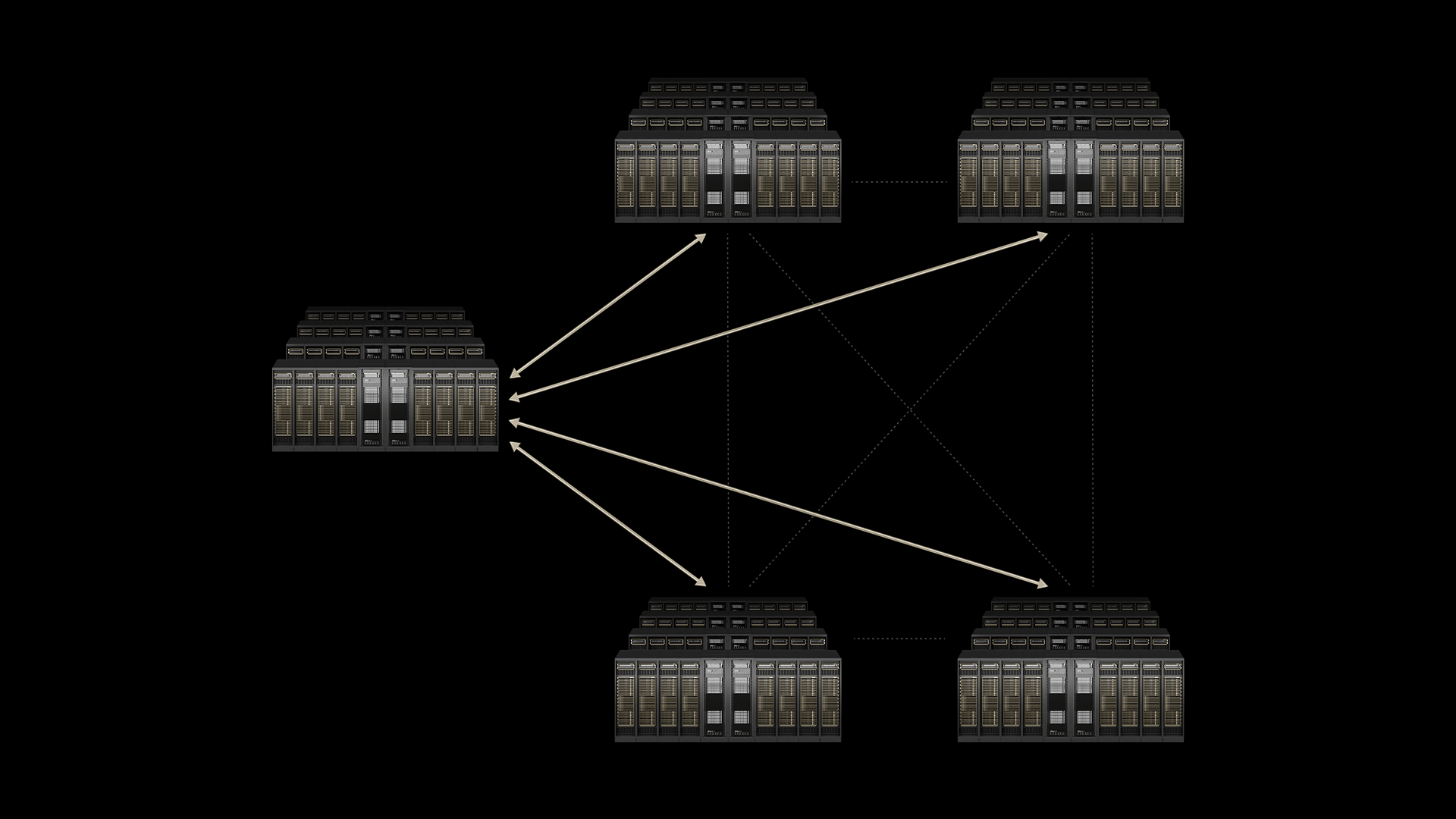

长久以来,AI计算架构的演进主要遵循两大范式:纵向扩展(Scale-up)和横向扩展(Scale-out)。在产业发展的早期,Scale-up是主要驱动力,其核心思想是不断增强单个节点的计算能力,即在一个单一的机柜内部,尽可能地集成更多的CPU、GPU、内存和硬盘,以提升垂直算力 。当单节点算力达到极限后,行业转向了横向扩展(Scale-out)。这种模式通过在单个数据中心内部,将更多的机柜互联起来,以增加计算节点的数量,从而实现算力池的扩大化 。然而,即使是横向扩展,也无法从根本上解决问题。单个数据中心在建设时,受制于电力供应、散热条件和土地面积等物理因素的硬性限制,其算力供给难以实现指数化的无上限扩张 。

AI算力瓶颈的终结者

正是在这种背景下,英伟达于8月24日宣布推出的NVIDIA® Spectrum-XGS以太网技术,为AI算力基础设施带来了一场革命性的范式变革。这项被称为“跨区域扩展”(Scale-across)的技术,旨在将分散在不同城市、国家乃至大洲的多个分布式数据中心,组合成为一个统一的、十亿瓦级的“AI超级工厂” 。黄仁勋将这一技术定义为AI计算继Scale-up和Scale-out之后的“第三大支柱” ,它标志着我们正在从一个追求局部效率最优的时代,迈向一个实现全局协同、资源统一调度的全新纪元。

产业逻辑重构

传统的AI基础设施建设,无论是Scale-up还是Scale-out,都主要聚焦于“局部优化”的问题。它们致力于在有限的物理空间内,通过提升硬件性能或增加互联节点来最大化算力产出。然而,AI大模型训练的内在需求,是对一个庞大、统一、低延迟的算力资源池的渴望,而地理位置上的分散性使得现有的“局部优化”方案难以满足这种需求。英伟达的Scale-across技术所做的,正是从根本上改变了AI算力供给的“地理”和“规模”维度,将原本一个个孤立的“算力孤岛”,通过超远距离、超低延迟的“高速公路”连接起来,整合成一个宏观的、可调度的“大水池” 。这种从“点”到“面”的思维转变,是理解这场产业逻辑重构的核心。

这一演进背后,存在一条清晰的链式传导路径。首先,AI算力需求的爆发式增长是所有变革的根本驱动力 。其次,单一数据中心在电力、散热、土地等方面的物理限制,构成了AI算力规模化扩张的硬性瓶颈 。正因为这个瓶颈无法通过简单的增量扩张解决,技术创新才被迫转向更深层次的突破。英伟达的Spectrum-XGS以太网,正是通过跨区域互联技术,从根本上绕开了单一数据中心的物理上限,实现了对算力资源的弹性供给 。这一技术路径的根本性转变,也直接导致了投资焦点的转移。未来的投资热点将不再仅仅聚焦于单一数据中心内部的高性能计算硬件,而是将目光投向实现这些数据中心之间高效、低延迟互联的“管道”和“中枢”——即那些将分散算力资源连接起来的“新基建”。这标志着投资逻辑从“计算”向“连接”的重大转向,预示着一个全新的投资赛道正在形成。

技术引擎解析

Spectrum-XGS以太网的发布,并非简单地将传统广域网(WAN)技术迁移至数据中心场景,而是在其Spectrum-X数据中心内部网络核心技术的基础上,针对跨区域AI通信的复杂需求,进行了深度的定制化优化 。它通过引入一系列创新性的技术架构,突破了现有商用以太网因高延迟、高抖动和性能不可预测性而带来的限制。

该技术的核心优势体现在三大关键支柱上:自适应的远距离拥塞控制、精准延迟管理、端到端遥测技术。通过这些技术,Spectrum-XGS以太网不仅实现了将多个分布式数据中心整合成一个统一的AI超级工厂,还带来了实实在在的性能飞跃。它提供了比传统以太网高1.6倍的带宽密度,并且在全面优化长距离连接性能的同时,有效降低了整体能耗和运营成本 。

值得注意的是,英伟达在光互联领域的布局远不止于此。英伟达与台积电合作开发的CPO(共封装光学)技术,通过将光引擎直接集成到交换机或处理器(XPU)封装内,极大地缩短了电信号传输路径 。这使得信号损耗从传统可插拔光模块的22dB大幅降至4dB左右,能效也因此提升了3.5倍 。CPO技术通过从根本上解决功耗和延迟问题,与Spectrum-XGS技术形成完美的协同,共同为构建未来的AI超级工厂奠定了坚实的物理和技术基础。

Scale-across三大核心增量产业链全景图

英伟达的Scale-across技术所描绘的AI新基建蓝图,离不开其背后三大核心增量产业链的协同发展:空芯光纤、相干光模块和光电路交换机(OCS)。这三者共同构成了连接AI超级工厂的“高速公路”,为投资者提供了全新的掘金赛道。

空芯光纤:超低延迟,超低衰减,高激光损伤阈值

相干光模块:高速率、小型化和低功耗

光电路交换机:超低延迟、高能效比、无阻塞带宽、拓扑重构能力

它们共同构成了一个紧密协同的AI新基建生态系统。空芯光纤提供了物理传输介质,相干光模块提供了高效、高带宽的信号收发能力,而OCS则扮演了智能“交通指挥官”的角色。这三者形成了“介质-收发-调度”的闭环,构成一个相互促进的“价值飞轮”。

结语:

英伟达Spectrum-XGS以太网的发布,不仅是一次技术上的迭代,更是AI产业为了突破自身增长瓶颈所进行的深层自我重构。它清晰地告诉我们,在计算需求永无止境的时代,连接的价值将愈发凸显。从单个机柜到单个数据中心,再到跨越地理边界的“超级工厂”,算力扩张的每一场战役都伴随着连接技术的深刻革新。

这场由“跨域”技术引发的“AI新基建”浪潮,正在重塑整个产业链的投资版图。对于任何有志于把握下一轮科技革命核心脉搏的投资者而言,理解并布局这一新范式,就是在抓住AI时代算力基础设施的核心脉络。空芯光纤、相干光模块与光电路交换机所构成的“黄金三角”,正预示着一个以“光”为核心的全新时代已经到来。

美股大数据 StockWe.com 是一个美国领先的金融和美股信息大数据提供商,紧盯华尔街金融市场和行情,2008年成立于美国硅谷,创始人是前纽约证券交易所资深分析师Ken,联合多位摩根斯坦利分析师,谷歌 Meta工程师利用AI和大数据,配合十多年美股实战经验和业内量化交易模型,每天处理千万级股票数据:挖掘潜力大牛股,捕捉期权异动大单,实时主力资金流向、机构持仓变化、川普突发新闻,精准买卖信号第一时间发到您手机APP。